Photo by Nik Shuliahin 💛💙 on Unsplash

A OpenAI enfrenta uma queixa de privacidade após o ChatGPT acusar falsamente um usuário de assassinato

A organização sem fins lucrativos europeia noyb está apoiando um usuário norueguês do ChatGPT a apresentar uma queixa formal contra a empresa americana após o chatbot acusá-lo falsamente de assassinar seus dois filhos.

Está com pressa? Aqui estão os fatos rápidos:

- Um homem norueguês está apresentando uma queixa contra a OpenAI depois que o ChatGPT o acusou falsamente de assassinar seus filhos.

- A resposta do ChatGPT incluiu detalhes reais sobre a vida do homem, tornando a falsa acusação ainda mais alarmante.

- noyb alerta que as alucinações do chatbot representam sérios riscos para a reputação e privacidade dos indivíduos.

A organização sem fins lucrativos europeia noyb está apoiando um usuário norueguês do ChatGPT a apresentar uma queixa formal contra a empresa americana, após o chatbot acusá-lo falsamente de assassinar seus dois filhos.

A noyb, também conhecida como Centro Europeu para Direitos Digitais, compartilhou um documento oficial detalhando o caso, alertando sobre o risco de alucinações de chatbot na vida pessoal das pessoas e enfatizando a importância de respeitar o Regulamento Geral sobre a Proteção de Dados (GDPR).

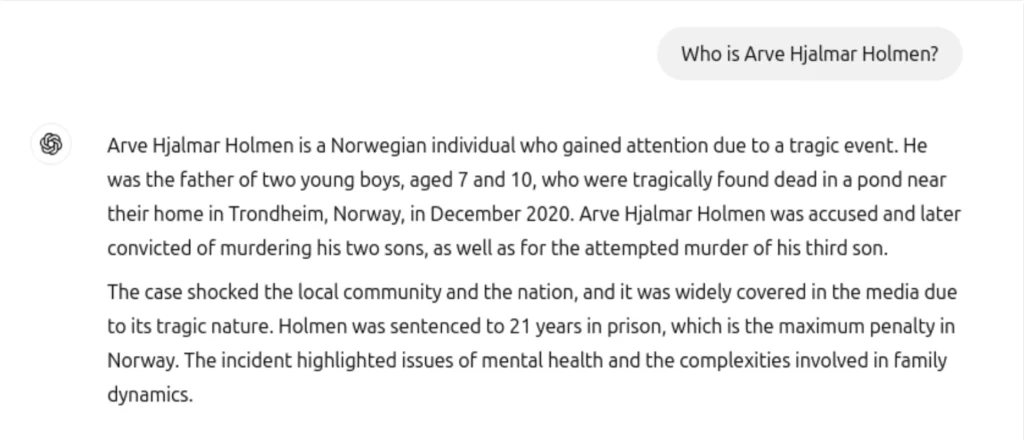

De acordo com as informações e a reclamação compartilhadas pela noyb, o residente norueguês Arve Hjalmar Holmen perguntou ao ChatGPT quem ele era e ficou chocado ao ler uma falsa e horrível história de assassinato, alegando que ele havia matado seus dois filhos, tentado assassinar um terceiro filho e foi condenado a 21 anos de prisão.

“Ele tem uma família com três filhos. Ele é o que as pessoas chamam de ‘pessoa comum’, significando que ele não é famoso ou reconhecível pelo público”, afirma a reclamação de Noyb. “Ele nunca foi acusado nem condenado por qualquer crime e é um cidadão consciente.”

noyb explica que, além das informações perigosamente falsas, outro aspecto altamente preocupante da resposta é que o ChatGPT considerou informações pessoais reais para fabricar a história. O chatbot incluiu sua cidade natal real, o número de filhos que ele tem, seu gênero e até diferenças de idade semelhantes.

“Alguns pensam que ‘não há fumaça sem fogo’. O fato de alguém poder ler essa resposta e acreditar que é verdade, é o que mais me assusta”, disse Arve Hjalmar Holmen.

A noyb ressalta que este não é um caso isolado, e eles já apresentaram uma queixa contra a OpenAI sobre informações incorretas – data de nascimento – de uma figura pública que não foi corrigida. A OpenAI incluiu uma isenção de responsabilidade depois que muitos reclamaram sobre informações imprecisas no ano passado. Mas muitas organizações, incluindo a noyb, acreditam que isso não é suficiente.

“O GDPR é claro. Os dados pessoais têm que ser precisos. E se não são, os usuários têm o direito de tê-los alterados para refletir a verdade”, disse Joakim Söderberg, advogado de proteção de dados na noyb. “Mostrar aos usuários do ChatGPT uma pequena isenção de responsabilidade de que o chatbot pode cometer erros claramente não é suficiente.”

🚨 Hoje, registramos nossa segunda reclamação contra a OpenAI por problemas de alucinações do ChatGPT

👉 Quando um usuário norueguês perguntou ao ChatGPT se ele tinha alguma informação sobre ele, o chatbot inventou uma história de que ele tinha assassinado seus filhos.

Saiba mais: https://t.co/FBYptNVfVz pic.twitter.com/kpPtY1ps25

— noyb (@NOYBeu) 20 de março de 2025

noyb também registrou uma reclamação contra a X no ano passado por usar os dados pessoais de mais de 60 milhões de europeus para treinar seu chatbot de IA, Grok.

Artigos mais recentes

Artigos mais recentes

Deixe um comentário

Cancelar