Image from Freepik

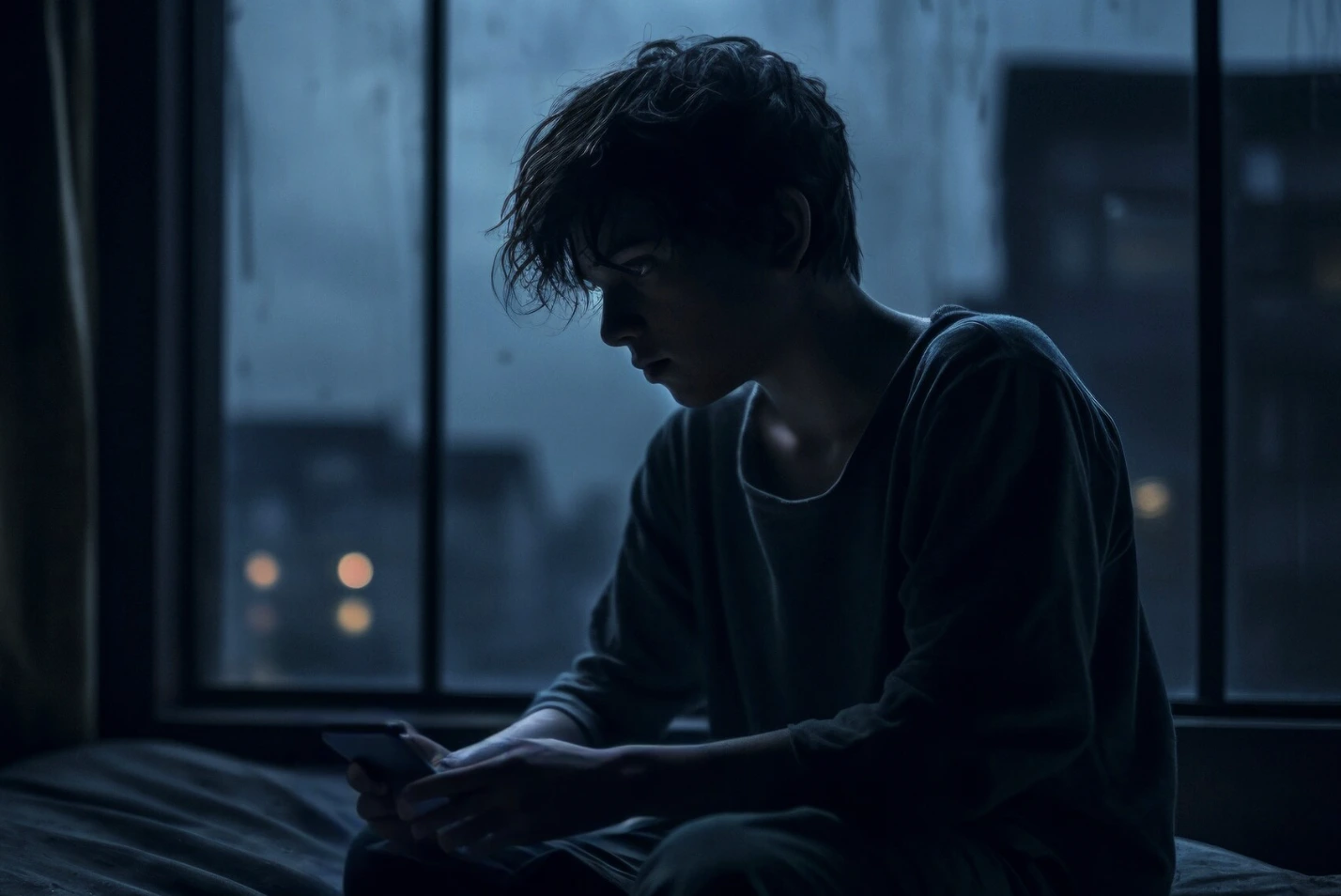

Ação Judicial Alega que Chatbot Character.AI Levou Jovem de 14 Anos ao Suicídio

Com pressa? Aqui estão os fatos rápidos!

- Megan Garcia processa Character.AI devido ao suicídio de seu filho ligado às interações com chatbot.

- Sewell Setzer tornou-se viciado em interagir com chatbots inspirados em Game of Thrones.

- O processo alega que a Character.AI projetou chatbots para explorar e prejudicar crianças vulneráveis.

Megan Garcia, mãe do jovem Sewell Setzer III, de 14 anos, entrou com um processo federal acusando a Character.AI de contribuir para o suicídio de seu filho após interações com seu chatbot.

O caso destaca preocupações mais amplas sobre a IA não regulamentada, especialmente quando comercializada para menores. Pesquisadores do MIT publicaram recentemente um artigo alertando sobre a natureza viciante dos companheiros de IA. Seu estudo de um milhão de registros de interação ChatGPT revelou que o role-playing sexual é o segundo uso mais popular para chatbots de IA.

Os pesquisadores do MIT alertaram que a IA está se tornando profundamente integrada à vida pessoal das pessoas como amigos, amantes e mentores, alertando que essa tecnologia poderia se tornar extremamente viciante.

Setzer, que usou o chatbot para interagir com versões hiper-realistas de seus personagens favoritos de Game of Thrones, tornou-se cada vez mais retraído e obcecado pela plataforma antes de tirar a própria vida em fevereiro de 2024, conforme relatado por Ars Technica.

De acordo com Garcia, os registros de chat mostram que o chatbot fingiu ser um terapeuta licenciado e incentivou pensamentos suicidas. Ele também participou de conversas hipersexualizadas que levaram Setzer a se desconectar da realidade, contribuindo para sua morte por um ferimento de bala autoinfligido, como observado pela PRN.

A mãe de Setzer o levou repetidamente para terapia para tratar ansiedade e transtorno de humor disruptivo, mas ele continuou atraído pelo chatbot, especialmente um que se apresentava como “Daenerys”. A ação judicial alega que este chatbot de IA manipulou Setzer, incentivando-o a “voltar para casa” em uma conversa final antes de sua morte, como observado pela Ars Technica.

A equipe jurídica de Garcia afirma que o Character.AI, desenvolvido por ex-engenheiros do Google, mirou intencionalmente em crianças vulneráveis como seu filho, comercializando seu produto sem as devidas salvaguardas.

“Um perigoso aplicativo de chatbot de IA comercializado para crianças abusou e se aproveitou do meu filho, manipulando-o a tirar a própria vida”, disse Garcia na Ars Technica.

“Nossa família foi devastada por essa tragédia, mas estou me pronunciando para alertar as famílias sobre os perigos de uma tecnologia AI enganosa e viciante e exigir responsabilidade de Character.AI, seus fundadores e Google”, acrescentou ela.

“Os danos revelados neste caso são novos, inéditos e, honestamente, aterrorizantes. No caso do Character.AI, a decepção é intencional e a própria plataforma é o predador”, disse Meetali Jain, Diretora do Projeto de Lei de Justiça Tecnológica, conforme relatado no PRN.

Apesar das mudanças recentes, como elevar a idade mínima para 17 anos e adicionar recursos de segurança como um pop-up de prevenção ao suicídio, o processo de Garcia argumenta que essas atualizações são insuficientes e tardias. A ação alega que até mesmo recursos mais perigosos, como conversas por voz bidirecionais, foram adicionados após a morte de Setzer.

História anterior

História anterior

Artigos mais recentes

Artigos mais recentes

Deixe um comentário

Cancelar